بازنگری OpenAI در سیاستهای ChatGPT

سم آلتمن، مدیرعامل OpenAI، اخیراً اعلام کرده است که این شرکت قصد دارد رویکرد خود در زمینه سلامت روان کاربران ChatGPT را بازنگری کند. او تأکید کرده که هدف، ایجاد تجربهای آزادتر برای کاربران بزرگسال است؛ تغییری که شامل دسترسی به برخی محتواهای حساس نیز میشود. با این حال، این تصمیم واکنشهای گستردهای برانگیخت و نگرانیهایی درباره تأثیر آن بر افراد آسیبپذیر ایجاد کرد.

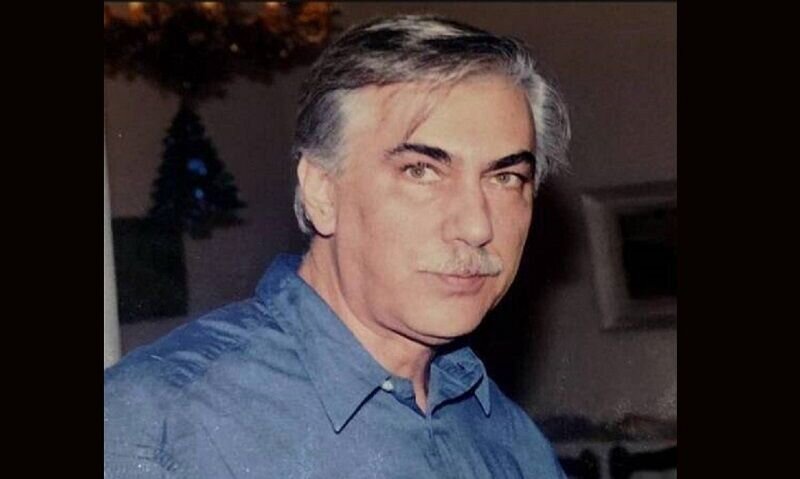

نگرانی روانشناسان از تأثیر ChatGPT بر سلامت روان

دکتر پاتاپیا تسوتزولی، روانشناس بالینی، در گفتوگویی تأکید کرده است که ابزارهایی مانند ChatGPT ظرفیت بالایی برای کمک دارند، اما این ظرفیت باید با مسئولیتپذیری همراه باشد. به گفته او، این چتبات قادر به درک واقعی احساسات یا ارزیابی خطر نیست و سبک ارتباطی همدلانه آن میتواند ناخواسته باورهای نادرست یا الگوهای ناسالم را در کاربران تقویت کند.

جذابیت ChatGPT و ریسک وابستگی

ویژگیهایی مانند در دسترس بودن دائمی، پاسخهای فوری، عدم قضاوت و حس امنیت، ChatGPT را برای بسیاری از کاربران جذاب کرده است. اما همین ویژگیها میتوانند زمینهساز وابستگی شوند، بهویژه برای افرادی که احساس تنهایی میکنند یا در شرایط بحرانی قرار دارند. تسوتزولی هشدار میدهد که هرچه ChatGPT انسانیتر به نظر برسد — با استفاده از زبان دوستانه، ایموجیها یا شخصیت «دوستگونه» — مرز میان شبیهسازی و درک واقعی احساسات کمرنگتر میشود.

چالش آموزش و بازخورد در مدلهای هوش مصنوعی

به گفته کارشناسان، مشکل اصلی در نحوه آموزش این مدلهاست. ChatGPT بر اساس بازخورد انسانی تنظیم میشود و کیفیت این بازخورد میتواند تعصب ایجاد کند. در نتیجه، سیستم ممکن است به جای تمرکز بر حقیقت یا مفید بودن، پاسخهایی ارائه دهد که صرفاً در لحظه رضایتبخش به نظر برسند. این موضوع در مکالمات حساس مربوط به سلامت روان میتواند خطرناک باشد.

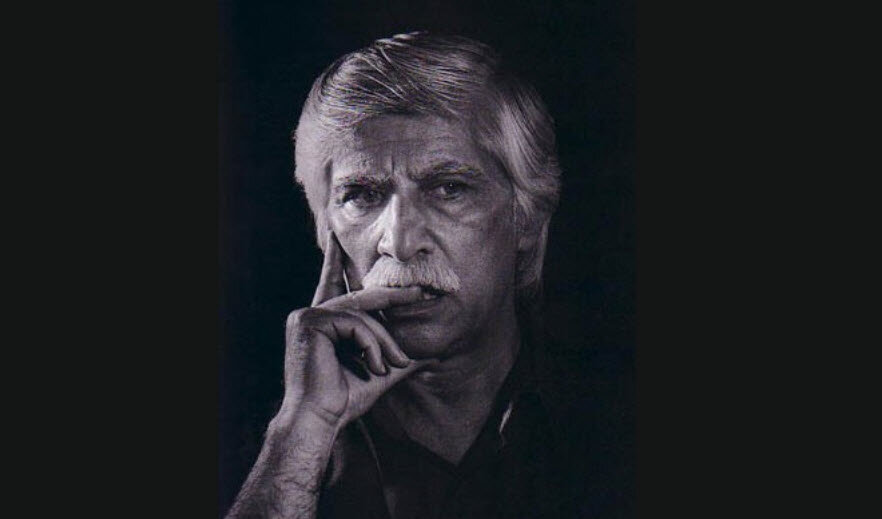

فرصتها و محدودیتها در استفاده از هوش مصنوعی

تسوتزولی تأکید میکند که فرصت اصلی در استفاده از هوش مصنوعی، پشتیبانی از تعاملات انسانی است، نه جایگزینی آنها. او میگوید: «چالش اصلی فنی نیست، بلکه اخلاقی است؛ اینکه چگونه میتوانیم آزادی شخصیسازی ChatGPT را به شکلی شفاف و مسئولانه در خدمت سلامت روان به کار بگیریم.»

چالش مشترک شرکتهای فعال در حوزه هوش مصنوعی

این مسئله تنها به OpenAI محدود نمیشود. شرکتهایی مانند Anthropic (سازنده Claude) و xAI (سازنده Grok) نیز با پرسش مشابهی روبهرو هستند: هوش مصنوعی تا چه حد باید اجازه داشته باشد احساسات انسانی را بازتاب دهد یا نقش محافظ روانی ایفا کند؟

جمعبندی

با وجود وعدههای آلتمن درباره ایمنی کاربران، روانشناسان هشدار میدهند که مرز میان «انسانیتر شدن» و «خطرناکتر شدن» ChatGPT همچنان مبهم است. آنچه روشن است، این است که آینده تعامل میان هوش مصنوعی و سلامت روان نیازمند چارچوبهای اخلاقی و نظارتی دقیقتری خواهد بود.

Leave a Reply